男子与“好友”视频通话10分钟,竟没了430万元!全国多地正在爆发……

广州普法

点开直播间乍一看,卖货的竟是当红女星。再定睛一看,“明星”其实是使用人工智能(AI)实时换脸技术的普通主播。他们冒充明星艺人,只为增加卖点,助力卖货……

近期,“AI换脸”的应用范围越来越广,但存在滥用之嫌,甚至有人利用AI换脸实施犯罪,例如伪造不雅视频、换脸诈骗等。前不久,就有一男子因“AI偷脸”,10分钟被骗430万元。5月22日,话题#AI诈骗正在全国爆发#冲上了微博热搜。

如此以假乱真,让人防不胜防。“AI换脸”的法律边界在哪?普通人又该如何防范?

01

公司老板遭遇AI换脸诈骗

10分钟被骗取430万元

近日,内蒙古包头警方发布一起利用AI实施电信诈骗的典型案例。

来自福建的郭先生是一家科技公司的法人代表。今年4月,他的“好友”突然通过微信视频联系他,称自己的朋友在外地竞标,需要430万元保证金,想借用郭先生公司的账户走账。

基于对好友的信任,加上已经视频聊天“核实”了身份,郭先生在10分钟内,先后分两笔把430万元转到了对方的银行账户上。

图源网络,图文无关

事后,郭先生拨打好友电话才得知被骗。原来,骗子通过AI换脸和拟声技术,佯装好友对其实施诈骗。“当时是给我打了视频的,我在视频中也确认了面孔和声音,所以才放松了戒备。”郭先生事后说。

值得注意的是,骗子并没使用一个仿真的好友微信添加郭先生为好友,而是直接用好友微信发起视频聊天,这也是郭先生被骗的原因之一。骗子极有可能通过技术手段盗用了郭先生好友的微信。

警方接报后,在银行的全力协助下,仅10分钟就将该诈骗账户内的336.84万元被骗资金拦截,但仍有93.16万元资金被转移,目前福建警方与包头警方正在全力追缴中。

02

AI换脸冒充明星带货

律师:或涉嫌侵权

除了佯装“熟人脸”实施诈骗,AI换脸还可能出现在直播带货中。最近,网上出现了一些“换脸直播”教程,教程发布者声称实时变脸软件可以帮助用户轻松“变脸”,极大地助力引流卖货。

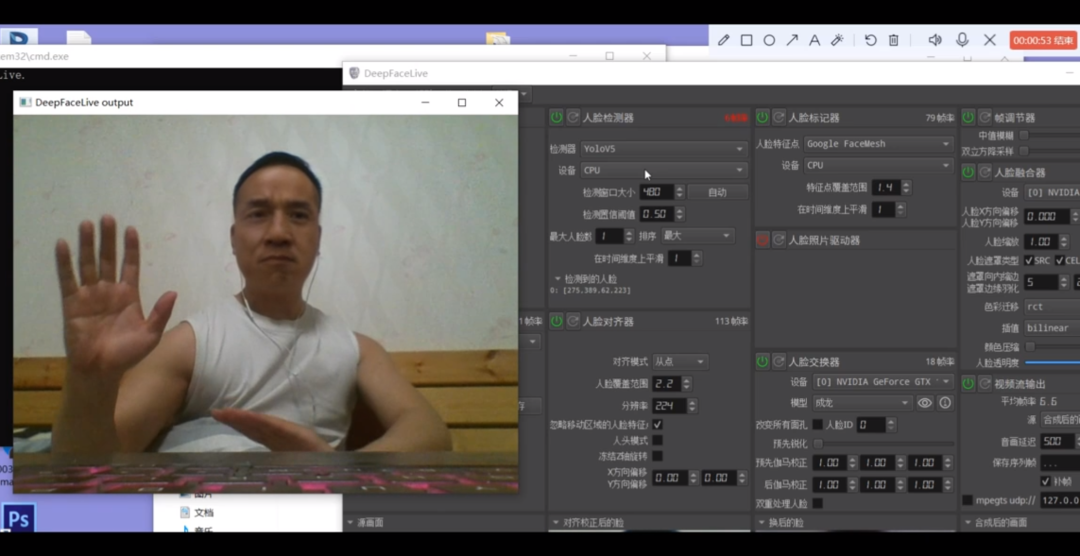

在一个展示换脸直播效果的视频中,使用者把名为“成龙”的模型载入相关软件后,摄像头前的人在直播画面中就有了与成龙相似的五官,但脸型和发型还保持原样。使用者歪头或变换表情时,五官动效切换得自然顺滑,只有手掌从脸前划过时,出现了比较明显的破绽。

△发布者展示换脸为“成龙”的

实时效果和软件界面(视频截图)

对此,北京岳成律师事务所高级合伙人岳屾山表示,换脸直播用于公开传播可能涉嫌侵犯相关明星艺人的肖像权。如果涉及直播带货等商业行为,会成为加重情节。

岳屾山解释,只要未经肖像权人同意,在直播中通过技术手段把自己的脸换成了明星的脸,就是对明星肖像的侵权。根据不同情况,承担的后果可能不同。即便只是娱乐,不涉及盈利行为,也属于侵权。如果把明星肖像用于带货直播,属于商业行为,在赔偿数额上一定会给予考虑。如果主观恶性、过错程度比较大,且因此获利,赔偿数额可能会更高。

一些使用换脸技术的直播并不会直接提到相关明星艺人的名字,但也不会主动声明或者否认。岳屾山认为,该行为涉嫌欺诈或是虚假宣传,让公众误以为就是明星在带货。如果货品本身质量不好,或者主播在带货过程中说的话或行为导致公众对被换脸的明星产生负面评价,明星可以主张名誉权的侵权责任。

03

骗子手段防不胜防

“AI诈骗”成功率竟近100%

在AI换脸的骗局中,骗子防不胜防的程度,超出正常认知的仿真度,令人不寒而栗。

据警方介绍,AI诈骗还有不少花样,通过声音合成、AI换脸、转发语音等手段,成功率竟接近100%。

AI技术如何介入新骗局?

有什么新的诈骗方式?

以下这些要注意了!

第一种是声音合成

骗子通过骚扰电话录音等来提取某人声音,获取素材后进行声音合成,从而可以用伪造的声音骗过对方。

图源湖北网警巡查执法

例如,某公司财务接到领导电话,要求立刻给供应商转款2万元,并将转账信息以邮件形式发送,转款理由是避免缴纳滞纳金。由于“老板”的口音十分逼真,该财务信以为真,在1小时内转款完成,后发现被骗。

第二种是AI换脸

因为人脸效果更易取得对方信任,骗子用AI技术换脸,可以伪装成任何人,再通过视频方式进行信息确认。

第三种是转发微信语音

除了AI换脸、合成语音外,还有一些诈骗手段也可谓防不胜防。在前不久,就有骗子通过转发微信语音的方式行骗。

在盗取微信号后,骗子便向其好友“借钱”,为取得对方的信任,他们会转发之前的语音,进而骗取钱款。尽管微信没有语音转发功能,但他们通过提取语音文件或安装非官方版本(插件),可实现语音转发。

第四种是AI筛选受骗人群

值得一提的是,这些骗局中,骗子并不是漫无目的地全面撒网,而是根据所要实施的骗术,通过AI技术筛选受骗人群,别有用心地锁定特定对象。例如,当进行金融诈骗时,经常搜集投资信息的小伙伴就会成为他们潜在的目标。

对于个人而言,除了在形形色色的“明星脸”中保持清醒,避免陷入虚假宣传,更重要的是面对花样翻新的AI诈骗,必须保持防范意识。

保护信息,提高警惕。不要轻易透露自己的身份证、银行卡、验证码等信息,不要轻易提供人脸、指纹等个人生物信息给他人,不过度公开或分享动图、视频等;

多重验证,确认身份。如果有人自称“熟人”“领导”等通过社交软件、短信以各种理由诱导汇款,或涉及网络转账交易行为时,务必通过电话、见面等多途径核验对方身份,不要未经核实随意转账汇款;

如不慎被骗或遇可疑情形,请注意保护证据,并立即拨打96110报警。

04

央视新闻评论:整治AI换脸

要用法打败“魔法”

“短短10分钟,被骗430万元”“换脸冒充当红女星带货,赚得盆满钵溢”……这种“换脸”术和拟声术,让人防不胜防。如此种种,无不说明换脸术的滥用,已经对公共利益构成威胁。

整治AI换脸,当用“法”打败“魔法”。

这个法,是方法、办法的法。有人说,防骗最有效的一招就是不信,无论对方怎么“换”、怎么变、怎么翻着花样骗,就是“不听不信不转账”。最关键的是,优化“打法”,升级高招,用更有效的方法“破防”。“魔高一尺,道高一丈”,面对骗子的新招数,我们的反诈术、防骗方法更要优化,总结出富有成效的好方法,并做好宣传普及,构筑反诈防骗的全民阵线。

这个法,也是法规、法律的法。此前,一款主打AI换脸的App很火,“只需一张照片,演遍天下好戏”。但很快,在监管部门约谈后,这款App下架,原因很简单,如此换脸侵犯了公民的肖像权。去年12月,《互联网信息服务深度合成管理规定》发布,对人脸生成、替换、操控,合成人声、仿声等都有明确约束。显然,随着制度设计更精准,相关立法更健全,AI换脸空间将越来越逼仄。

AI换脸术滥用,也促使大家思考一个深层次问题。新技术不断面世,带给了人们便利,但可能被居心叵测之徒非法利用。人们固然不能因噎废食,但也不能忽略它的双刃剑效应。如果缺乏应有规束,AI换脸则可能打开潘多拉魔盒。因势利导,使其趋利避害,这是我们要全力做到的。

来源:广州普法综合自央视新闻、广州日报、南方日报等(封面图来源于网络,与本文内容无关)

(*声明:本号所发布的文章中包含律师解析的内容仅为其个人的专业意见表达,不代表本平台的任何观点与立场)

*温馨提示:如果本号转载的稿件涉及您的版权、名誉权等问题,请尽快留言与我们联系,经核实相关情况后,我们将会妥善处理。投稿邮箱:ycpf_sf@gz.gov.cn

正在请求数据,请稍候!

正在请求数据,请稍候!